英伟达 Holodeck 国内亮相,在 VR 中看跑车“炸裂”是怎样的体验?

本文作者:田苗 2017-08-24 18:23

北京国际广播电影电视设备展览会(BIRTV)是中国最具权威的广播电影电视专业设备综合展览会,每年我们都会从这场展览会上看到最新的影视技术和设备。

其实,英伟达早就不是我们印象中的“电脑芯片”公司了。今年 5 月的 GTC 大会上,英伟达 CEO 黄仁勋发表了时长 2 小时的主题演讲,内容涵盖 VR、GPU 云服务、自动驾驶芯片、深度学习、机器人训练等等,期间推出了 VRWork Audio SDK,用于在 VR 中实现立体声效。不久前的 SIGGRAPH 大会上,我们了解到,影视级专业相机 Z CAM V1 PRO 就集成了 VRWork SDK,可实现 360 度 VR 立体直播。

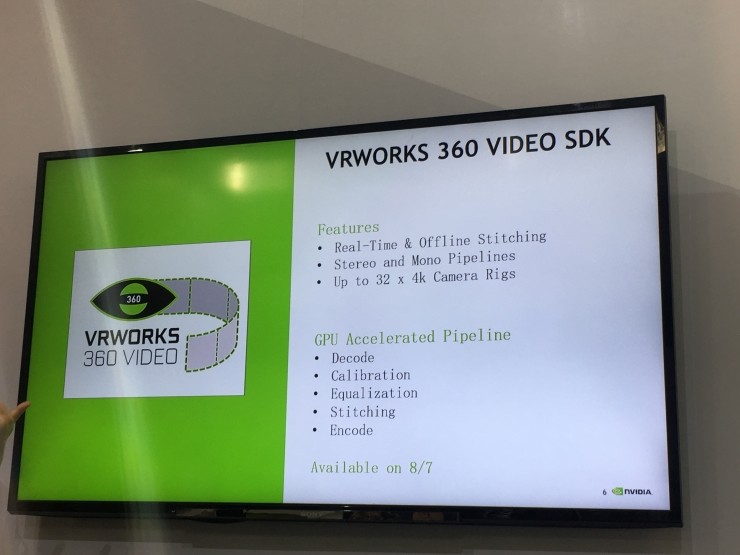

VRWorks 360 Video SDK

目前,360 度 VR 全景视频是电影电视行业不断探索的方向,这也就不奇怪为什么英伟达会参加 BIRTV。

现场,英伟达的 VR 相关负责人介绍了针对 VR 领域,VRWork 所能做的事情包括四个方面:模拟真实世界的触感,模拟立体声效,实现更好、更高效的画面渲染,以及 360 度视频拍摄和直播。

2016 年的 SIGGRAPH 大会上,他们便推出了 LIVE 360 Mono,但当时音效只能实现单声道,今年则实现了立体声效。

VRWorks 360 Video SDK 支持实时和后期制作的 360 度单声道和立体声工作流程,可支持:

• 4K 摄像机实时& 离线视频拼接

• GPU 加速的视频解码、校准、拼接和编码

• 360 度投影至立体地图和全景

• GPUDirect for Video,可实现低延迟视频采集

• 多达 32 路视频流

• GPU 加速的视频解码、校准、拼接和编码

• 360 度投影至立体地图和全景

• GPUDirect for Video,可实现低延迟视频采集

• 多达 32 路视频流

该 SDK 免费开放,可登陆其官网进行下载。

英伟达工作人员表示画面拼接的关键在于,

“全景相机由多个摄像头构成,各个摄像头之间会有画面重叠的部分,并且可能不在同一个时间点,画面拼接时必须在同一个时序里面;二是两个临近的摄像头拍摄时,如何识别出画面重合的部分,拼接完可能会漏掉,我们一定会做‘补洞’、‘补光’。”

“我们的 GPU 效率可能更高,这是涉及硬件层面的架构。”

“全景相机由多个摄像头构成,各个摄像头之间会有画面重叠的部分,并且可能不在同一个时间点,画面拼接时必须在同一个时序里面;二是两个临近的摄像头拍摄时,如何识别出画面重合的部分,拼接完可能会漏掉,我们一定会做‘补洞’、‘补光’。”

“我们的 GPU 效率可能更高,这是涉及硬件层面的架构。”

Project Holodeck

除了全景视频,这次他们还把 Holodeck 的演示片段带到了现场。

Holodeck 的演示 Demo 十分简单,直观些说,这是针对汽车设计者制作的内容。Demo 中你会看到一辆价值不菲的跑车,你可以随意调整汽车的颜色(外观和车座),可以拿着标尺测量车轮的大小,可以站在车外“透视”到前车盖下的发动机,还可以让整辆车全部“炸开”,看到跑车的各个零件,并且“游走”在这些零件间(这是比较震撼的场景)。

由于展会场地条件的限制,现场网络状况不好,雷锋网没有体验到“多人协作”的模式(但在 SIGGRAPH 上雷锋网(公众号:雷锋网)其他编辑体验过多人模式)。

工作人员表示,Demo 中的跑车使用了 5000 多万个面,至于 Holodeck 下一步到底具体怎么用,现在还没有确定,要等 9 月份北京举办的 GTC 大会上的新消息。

此前雷锋网在 SIGGRAPH 大会上对 Holodeck 有过较为详细的报道,英伟达专业 VR 业务主管 David Weinstein 透露,Holodeck 将在 9 月进行内测,届时会邀请一部分合作伙伴参与,收集各方反馈对 Holodeck 进行优化。他也反复强调,Holodeck 现在只是一个项目,不能算产品,只有在完善到一定程度之后才会公测。

作为一个架构,英伟达会把 Holodeck 提供给游戏、娱乐与工作应用开发商,用于开发它们的具体产品。

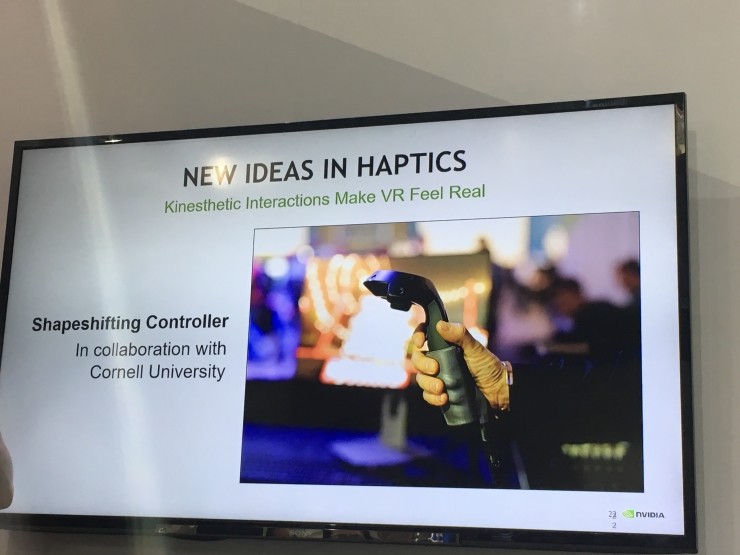

英伟达的工作人员还透露了一些他们正在试验室里做的事情。例如,现有的 HTC Vive 手柄只能够震动,如果让手柄实现力反馈,这将大大增强沉浸感;还有 SIGGRAPH 上展示过的“变焦虚拟:近眼现实的新型光学结构(Varifocal Virtuality: A Novel Optical Layout for Near-Eye Display)”。